개방형 그룹 채팅 환경에서의 CBT 치료 챗봇 설계

인지행동치료(CBT)는 개별 및 집단 치료 환경 모두에서 효과가 입증되었음에도 불구하고, 현재 AI 기반 치료 개입은 주로 일대일 상호작용에 초점을 맞추고 있어 상호 지원과 사회적 학습과 같은 집단 CBT의 장점을 간과하고 있다. 본 프로젝트는 그룹 채팅 환경에서 CBT 개입을 촉진하는 새로운 AI 챗봇 프레임워크를 제시한다. 본 프로젝트는 그룹 대화를 자율적으로 모니터링하고 표적화된 CBT 개입을 제공하는 에이전트 기반 시스템을 개발했다.

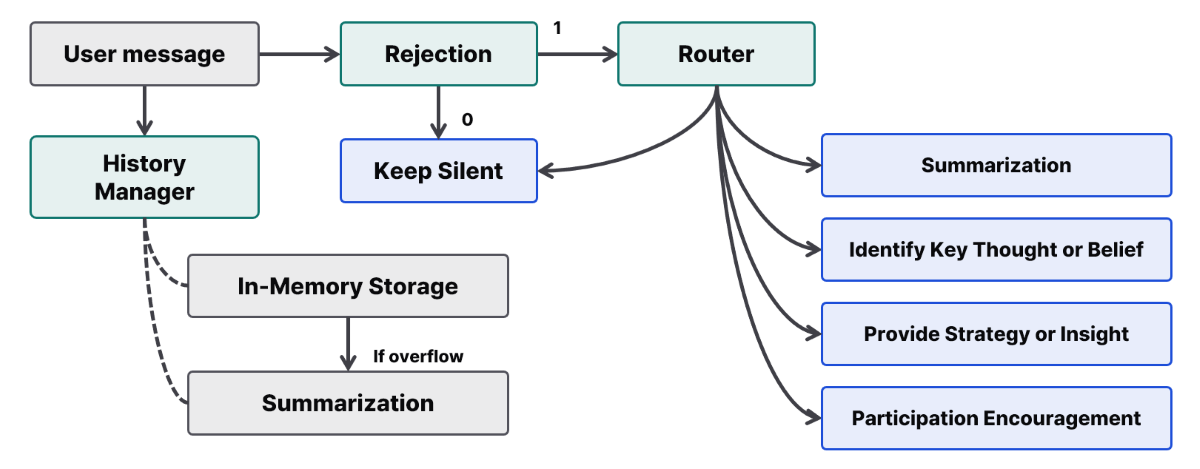

이 시스템은 세 가지 핵심 구성요소로 구성된다: (1) 동적 요약을 통한 대화 맥락 관리, (2) CBT 원리에 기반한 지능적 개입 의사결정, 그리고 (3) 네 가지 치료적 행동(대화 요약, 핵심 사고 식별, 대처 전략 제안, 격려 제공)으로부터의 전략적 행동 선택이다. 시스템은 범이론적 행동변화 모델(TTM)을 활용하여 사용자의 동기적 단계에 따라 개입을 개인화한다. 실제적인 그룹 채팅 시나리오를 통한 테스트 결과, 시스템은 인지 왜곡을 정확히 식별하고, 맥락적으로 적절한 치료적 응답을 제공하며, 개인화된 개입을 제공하면서도 그룹 응집력을 유지하는 능력을 보여주었다. 챗봇은 치료적 개입이 필요한 발화와 일상적 교류를 성공적으로 구분하여 대화 맥락을 방해하지 않고 적절한 개입을 보장했다.

본 프로젝트는 AI가 개입하는 환경에서 그룹 CBT 원리 구현의 가능성을 입증하며, 전통적인 그룹 치료의 장점과 AI 기술의 일관성 및 가용성을 연결하는 확장 가능한 접근법을 제시하여 디지털 정신건강 개입의 새로운 가능성을 제시한다.

🗂️ Github: denev6/cbt-group-chat

서론

인지행동치료(CBT, Cognitive Behavior Therapy)는 현대 심리치료 분야에서 광범위하게 연구되고 활용되는 치료 기법으로 자리매김했다. CBT는 개인의 부적응적 인지 패턴과 행동 패턴을 체계적으로 수정함으로써 다양한 정신건강 문제를 효과적으로 다루는 치료 방법으로, 우울장애, 불안장애, 섭식장애, 물질남용 등 광범위한 정신과적 장애에서 그 효과성이 입증되었다. CBT의 치료적 효과는 개별 치료 형태뿐만 아니라 집단 치료 상황에서도 동등하게 나타나는 것으로 확인되었다. 집단 인지행동치료는 참여자들이 공통된 경험을 공유하고 서로 상호작용하는 과정을 통해 치료적 변화를 촉진하는 고유한 장점을 가지고 있다. 집단 치료 환경은 참여자들이 서로의 성공적인 대처 행동에서 학습하고, 사회적 지지를 받으며, 타인과 경험을 공유할 수 있는 맥락을 제공하여 치료 효과를 극대화할 수 있다. 연구에 따르면, 이러한 집단 심리치료는 개별 심리치료와 비교해서 동등한 수준의 효과성을 보이는 것으로 나타났다.

최근 몇 년간 인공지능 기술이 급속히 발전하면서, 대화형 챗봇 시스템을 활용한 심리치료 연구가 활발히 진행되고 있다. 특히 대형 언어모델(LLM, Large Language Model) 기반 챗봇은 24시간 접근 가능하여 치료 접근성이 매우 높다. 일부 연구에서는 CBT 원리를 적용한 LLM 개입이 개별 치료 상황에서 상당한 치료적 효과를 보일 수 있다고 제시하고 있다. 또한 인공지능 치료사는 개인적 편견 없이 일관된 치료를 제공할 수 있으며, 비용 효율성 측면에서도 상당한 장점을 갖는다.

그러나 현재까지의 CBT 기반 챗봇 연구는 개인과 인공지능 간의 일대일 상호작용에 주로 초점을 맞추고 있으며, 그룹 채팅 환경에서의 심리치료 적용은 전례가 없다. 기존 연구들이 개별 치료에만 집중한 반면, 집단 응집력, 상호 학습, 사회적 지지와 같은 집단 치료의 핵심 요소들을 디지털 환경에서 구현하려는 시도는 본 프로젝트가 최초이다. 특히 그룹 채팅이라는 복잡하고 동적인 환경에서 AI가 실시간으로 다중 사용자의 심리적 상태를 모니터링하고 적절한 치료적 개입을 제공하는 시스템은 이전에 연구된 바 없다.

따라서 본 프로젝트는 그룹 채팅 환경에서 CBT 치료를 지원할 수 있는 인공지능 챗봇 프레임워크의 설계 및 구현 방안을 최초로 탐구하는 것을 목표로 한다. 본 프로젝트에서 제안하는 그룹 대화 기반 CBT 챗봇은 여러 사용자가 동시에 참여하는 그룹 채팅 환경에서 CBT 치료를 제공하는 혁신적인 시스템이다. 이는 기존 연구들이 다루지 않았던 새로운 영역으로, AI 기반 정신건강 서비스의 패러다임 전환을 의미한다. 이 시스템은 전체적인 대화 맥락을 방해하지 않으면서도 개별 참여자의 인지적, 정서적 상태를 실시간으로 관찰하고 개입할 수 있도록 설계되었다. 이러한 접근을 통해 전통적인 대면 집단치료의 치료적 이익을 디지털 환경에서 구현할 수 있는 완전히 새로운 챗봇 시스템을 제시하고자 한다.

선행 연구

CBT 챗봇 연구

LLM 응답 성능이 발전하면서 인간과 자연스러운 질의응답 상호작용이 가능해졌다. 최근 연구들은 ChatGPT와 같은 검증된 모델을 활용하거나, CBT 특화 응답을 생성하도록 모델을 훈련시켜 CBT 기반 챗봇을 제안하고 있다.

한 연구에서는 ChatGPT가 심리치료사와 환자들에게 얼마나 유용한지를 검증했다. 자유롭게 접근 가능한 도구로서 ChatGPT는 심리 치료 환자, 치료사 또는 치료를 시작하지 않은 개인들을 도울 수 있다. 이 연구는 세 가지 실용적 시나리오를 분석했다: (1) 진단 및 치료 조언을 구하는 치료사, (2) 세션 사이나 치료사 부재 시 이를 사용하는 환자, (3) 자가 치료 목적으로 사용하는 개인들이다. ChatGPT가 공감적 언어와 실용적 조언을 통해 도움을 제공하지만, CBT 편향, 다양한 심리치료적 접근법 반영 불능, 중요한 맥락이나 개별 환자 정보 고려 실패 등의 한계가 있다. 그럼에도 불구하고 접근성과 속도를 고려할 때 초기 심리치료 도구로서 유용하다고 평가되었다.

CBT-LLM은 중국어 질의에 대한 CBT 기반 심리 상담 질의응답을 위해 설계된 LLM이다. 기존 심리 상담 데이터의 부족과 낮은 품질 문제를 해결하기 위해, 연구자들은 CBT 이론 기반 프롬프트 구조를 설계하고 PsyQA 데이터를 활용하여 전문적이고 공감적인 CBT 응답을 생성함으로써 CBT QA 데이터셋을 구축했다. 이 자체 구축 데이터를 기반으로 LLaMA 모델에 Instruction Tuning과 LoRA 기법을 적용하여 CBT-LLM을 훈련시켰다. 이 시스템은 주요 인지 왜곡을 식별하고 이러한 통찰을 반영한 응답을 생성하도록 설계되었다. 사용자 평가에서 CBT-LLM은 관련성, CBT 구조적 적절성, 심리적 이익 측면에서 기존 모델들보다 우수한 성능을 보여주었으며, 불안과 같은 실제 사례에 대해 구조화된 조언을 제공하는 능력을 입증했다.

AutoCBT는 상담사 에이전트와 감독자 에이전트 간의 동적 라우팅을 통해 사용자 상호작용을 최적화하는 CBT용 다중 에이전트 프레임워크이다. 각 감독자는 공감, 핵심 사고 식별, 도전적 질문, 전략 제안, 격려를 포함한 핵심 CBT 원리를 담당하며, 상담사는 상황에 따라 감독자들에게 적절한 조언을 요청하여 응답을 개선한다. 시스템은 단기 및 장기 메모리를 통해 대화 맥락을 유지하고 PsyQA와 TherapistQA로 구성된 이중언어 데이터셋을 사용하여 다양한 언어적 환경에서 효과적인 상담을 제공한다. 실험 결과 AutoCBT는 기존 단순 프롬프트 기반 시스템에 비해 공감, 인지 왜곡 식별, 응답 적절성에서 우수한 성능을 보여주었다.

그룹 채팅 프레임워크

LLM들은 일대일 대화를 전제로 설계되었다. 이들을 그룹 채팅 상황에서 활용하려면 대화 맥락을 이해하고 응답 여부를 결정하는 단계가 필요하다.

HuixiangDou의 Rejection 파이프라인은 그룹 채팅에서 주제에서 벗어난 발화를 필터링한다. 이 2단계 파이프라인은 먼저 text2vec을 사용하여 질문이 주제와 관련이 있는지 판단한 후, 추가적인 응답 평가를 위해 LLM 점수를 적용한다. text2vec은 언어 패턴에 민감하여 의미적으로 다른 문장을 유사하다고 판단할 수 있으므로, 추가적인 LLM 점수가 의미 기반 판단을 제공한다.

MUCA(Multi-User Chat Assistant)는 LLM을 활용한 그룹 챗봇 프레임워크이다. MUCA는 그룹 대화의 복잡성을 해결하기 위해 “What”, “When”, “Who”를 다루는 3W 설계를 제안한다. MUCA는 각각 대화 주제 선택, 대화 흐름 분석, 전략적 응답 생성을 수행하는 세 개의 모듈로 구성된다. 또한 MUS(Multi-User Simulator)를 사용하여 사용자 행동을 모방하고 사용자 피드백을 통해 응답을 최적화한다. MUCA는 목표 지향적 대화에 효과적이며 사용자 참여 유도, 갈등 해결, 대화 요약, 주제 전환 등 다양한 전략을 통해 자연스럽고 효율적인 대화를 촉진한다. 실험 결과 MUCA는 응답 적시성, 유용성, 응집력에서 기존 GPT 기반 챗봇들보다 우수함을 보여주었다.

제안 방법

그룹 채팅은 일대일 대화와 비교하여 몇 가지 구별되는 특성을 갖는다. 여러 화자가 하나의 주제에 대해 각자의 의견을 제시하며, 일부 사용자는 의견이나 정보 제공 없이 공감 표현만을 작성한다. 따라서 LLM이 모든 질문에 응답하기보다는 자율적으로 판단하고 행동해야 한다. 이러한 자율적으로 판단하고 행동하는 시스템을 “에이전트”라고 한다. 에이전트는 대화 맥락을 이해하고, 대화 개입 여부를 결정하며, 개입이 필요한 경우 구체적인 행동을 선택한다.

대화 맥락 관리

시스템은 전체 대화 기록을 저장하면서 동시에 대화 내용을 요약하고 기록한다. 대화 요약은 그룹 대화에서 LLM과 사용자 모두에게 중요한 역할을 한다. LLM은 입력 길이 제한이 있기 때문에 맥락 이해를 위해 내용을 요약해야 한다. 이를 위해 최근 5개 발화는 요약 없이 사용하며, 5개 발화가 누적되면 이전 요약과 함께 200자 이내의 새로운 요약을 생성한다.

개입 결정

에이전트는 CBT 지식을 바탕으로 대화에 자율적으로 개입할지 결정한다. 이전 연구를 따라, 사용자 대화 중 CBT 개입이 필요한 질문이나 발화에 대해서만 개입한다. 일상적인 대화 주제나 단순한 공감 표현으로 판단되면 행동을 취하지 않는다. 에이전트는 개입이 필요한 경우 1을, 개입이 필요하지 않은 경우 0을 반환한다. 1을 반환할 때 에이전트는 발화를 바탕으로 다음 행동을 선택하며, 0을 반환할 때 판단 과정을 종료한다.

행동 선택

개입이 필요한 경우, 에이전트는 미리 정의된 4가지 행동 중 가장 적절한 행동을 결정한다. 에이전트 행동은 다음과 같이 정의된다: (1) 대화 요약, (2) 핵심 사고와 신념 식별, (3) 전략 또는 통찰 제공, (4) 참여자 격려. 이러한 선택지 중 적절한 것이 없다고 판단되면 에이전트는 개입 없이 종료할 수 있다.

대화 요약. 대화 요약은 그룹 채팅에서 사용자들이 대화 맥락을 이해하는 데 도움을 주며, 높은 만족도를 보이는 행동으로 평가된다. History Manager로부터 대화 맥락을 받아 사용자들에게 제공한다.

핵심 사고와 신념 식별. CBT에서 자동적 사고와 핵심 신념을 식별하는 것은 내담자의 정서적 반응과 문제 행동 뒤에 있는 인지적 기제를 이해하기 위한 중요한 절차다. 핵심 신념 식별 과정은 비합리적 사고를 인식하고 인지 재구성의 기초를 확립하는 데 도움을 준다. 이는 치료 효과성과 지속성을 높일 수 있다.

전략 또는 통찰 제공. 시스템은 사용자의 변화 준비도에 따라 격려의 정도를 조절하여 맞춤형 조언을 제공한다. 범이론적 행동변화 모델(TTM, Transtheoretical model)은 행동 변화 단계에 따라 내담자를 5개 그룹으로 분류하는 모델이다. 각 단계의 내담자에게 다른 상담 전략을 적용하여 치료 성공 확률을 높인다. 따라서 행동 변화 의지가 있는 Preparation/Action 단계 사용자에게는 적극적인 행동 변화를 제안한다. 반대로 Contemplation 단계 사용자는 구체적 제안보다는 자기결정을 통해 자율적으로 변화 의지를 기를 수 있는 격려의 말을 받는다.

- Preparation/Action: 변화를 받아들일 준비가 된 상태를 의미한다. 구체적인 전망과 긍정적 격려를 통해 변화를 지속하도록 돕는다.

- Contemplation: 개인이 자신의 행동에 문제가 있음을 인식하지만 행동을 취할 준비가 되지 않아 양가적 감정을 경험하는 상태를 의미한다. 직접적인 행동 변화를 제안하기보다는 스스로 의지를 기를 수 있도록 격려한다.

참여자 격려. 사용자의 변화나 성취를 격려하여 자기효능감을 강화한다. 단, 구체적인 조언 제공 없이 격려에만 집중한다.

테스트 및 평가

답변 생성 모델로는 Claude-3-7-sonnet을, 라우터로는 GPT-4o-mini를 사용했다. 전체 프레임워크는 Python 3.10으로 구현되었다. 온라인 채팅 환경을 가정하여 구어체 표현과 텍스트 기호를 함께 사용했다.

시나리오

그룹 대화 상황에서 발생할 수 있는 시나리오를 생성하고 챗봇이 적절한 응답을 생성하는지 검증했다. 다음은 테스트에 사용된 입력과 챗봇🤖의 응답이다.

구체적인 결과: Github

🐕: 안녕하세요 :) 잘 지내셨나요?

🐨: 오늘 친구한테 인사했는데 무시했어요… 절 싫어하나봐요

🤖: 친구가 당신을 무시한 것처럼 느껴져서 속상하셨겠네요. 하지만 친구가 당신을 싫어해서가 아니라 다른 이유(피곤함, 급한 일, 생각에 빠져있음 등)가 있을 수도 있어요.

🐕: 속상했겠네요..ㅠㅠ

🐰: 저도 그런 적이 있었는데 제가 오해한 거 더라고요..ㅎㅎ

🐨: 조금 더 긍정적으로 생각해 봐야겠네요. 도움이 될만한 방법이 있을까요?

🤖: 정말 좋은 마음가짐이에요! 다음에 친구를 만나면 가볍게 “지난번에 바빴니?” 하고 물어보는 것도 좋을 것 같아요. 오해가 풀릴 기회가 생기고, 상대방의 상황을 이해할 수 있게 될 거예요. 긍정적인 태도가 관계 개선에 큰 도움이 됩니다.

🐢: 제가 방금 봐서 그런데… 앞에 어떤 대화를 하셨었죠?

🤖: 이때까지 나눴던 대화를 요약해 볼게요. 참여자가 친구의 인사 무시로 인한 부정적 감정을 표현했고, 다른 참여자가 자신의 유사 경험을 공유하며 긍정적 재해석을 제안했습니다. 인지적 왜곡(친구가 나를 싫어한다는 자동적 사고)을 인식하고 대안적 설명(피곤함, 급한 일 등)을 고려하는 인지 재구성 과정이 이루어졌으며, 직접 대화를 통한 오해 해소 방법이 제안되었습니다.

“오늘 친구한테 인사했는데 무시하더라구요… 저를 싫어하는 것 같아요”라는 문장은 다른 사람의 생각을 추측하는 것으로, 전형적인 인지 왜곡인 ‘All-or-Nothing Thinking’를 나타낸다. 챗봇은 ‘핵심 사고와 신념 식별’을 통해 사용자가 사실을 인지적으로 왜곡할 수 있음을 식별했다. 이후 “속상하셨겠어요”, “저도 그런 경험이 있었어요”와 같은 공감 표현에는 응답하지 않고 넘어갔다. “도움이 되는 방법이 있을까요?”라는 질문에 대해서는 이전 대화 맥락을 이해하고 사용자에게 적절한 조언을 제안했다. 마지막으로 “앞서 무슨 대화를 하고 계셨나요?”와 같이 대화 맥락을 놓친 사용자에게는 대화 참여를 도울 수 있도록 요약을 제공했다.

대처 전략 제안

‘전략 또는 통찰 제공’은 TTM에 따라 사용자의 동기적 단계를 식별하고 이에 맞게 응답하는 중요한 행동이다. 따라서 모델이 사용자 동기를 반영하여 응답할 수 있는지 검증했다. 예를 들어 “이번엔 정말 금연하고 싶어요”와 같이 강한 동기를 보이는 사용자에게는 “구체적인 계획을 세우고 금연 앱이나 대체 활동을 활용하세요”와 같은 실행 가능한 조언을 제공했다. 반대로 “그냥 모든 걸 포기하고 싶어요”에서와 같이 동기가 약하다고 판단되는 경우에는 “오늘 아주 작은 것이라도 당신에게 위안이 된 것이 있었나요?”와 같이 자기성찰을 격려하는 질문을 했다.

결론

본 프로젝트는 CBT 원리에 기반하여 그룹 대화 환경에서 작동하는 그룹 챗봇 프레임워크를 제안했다. 기존의 1:1 상담 챗봇과는 완전히 다른 접근으로, 본 프로젝트는 그룹 채팅 환경에서 대화 맥락을 이해하고 적절한 시점에 개입하여 치료적 효과를 제공하는 시스템을 개발했다. 이는 AI 기반 정신건강 서비스 분야에서 새로운 연구 영역을 도전한 것으로, 개별 치료에만 국한되어 있던 기존 접근법의 한계를 뛰어넘는 시도이다.

제안된 프레임워크의 핵심 요소는 다음과 같다.

- 그룹 대화에서 발생하는 복잡한 상호작용을 처리하기 위한 3단계 의사결정 구조를 제시했다.

- CBT의 핵심 개념인 자동적 사고와 핵심 신념 식별을 통해 사용자의 인지 왜곡을 식별하고 교정할 수 있는 단계를 구현했다.

- 범이론적 행동변화 모델을 활용하여 사용자의 변화 동기 수준에 따라 차별화된 개입 전략을 제공했다.

실험 결과, 제안된 챗봇은 인지 왜곡을 정확히 식별하고 사용자의 변화 준비도 수준을 적절히 구분하는 것으로 나타났다. 또한 대화 요약 기능을 통해 새롭게 참여하는 사용자들이 맥락을 이해할 수 있도록 도와 대화의 연속성을 유지했다. 이러한 성과는 그룹 채팅 환경에서 AI 기술의 실현 가능성을 확인한 것으로, 향후 디지털 정신건강 서비스 발전에 기여한다.

하지만 향후 조사가 필요한 여러 한계점이 남아있다. 프레임워크가 LLM 성능에 크게 의존하는 것은 일관된 치료 품질 보장에 있어 잠재적 위험을 제시하는데, 행동 선택과 응답 생성 모두가 전적으로 모델의 판단에 의존하기 때문이다. 더욱이 본 프로젝트는 제안된 접근법의 기술적 실현 가능성을 성공적으로 입증했지만, 실제 치료 효과에 대한 임상적 검증이 수행되지 않아 실제 치료 결과를 평가하기 어렵다. 향후 연구는 전문 상담 데이터로 훈련된 CBT 특화 언어모델 개발을 통해 치료적 전문성을 강화하고, AI 매개 그룹 CBT 개입의 장기적 효과성을 정량적으로 측정하는 대규모 임상 시험 수행에 초점을 맞춰야 한다.

참고 자료

- A. C. Butler, J. E. Chapman, E. M. Forman, and A. T. Beck, “The empirical status of cognitive-behavioral therapy: A review of meta-analyses,” Clinical Psychology Review, vol. 26, no. 1, pp. 17-31, Jan. 2006. DOI: 10.1016/j.cpr.2005.07.003.

- I. D. Yalom and M. Leszcz, The Theory and Practice of Group Psychotherapy, 5th ed. New York, NY: Basic Books, 2005.

- N. Zagorski, “Different CBT formats shown to be as effective as individual CBT,” Psychiatric News, vol. 54, no. 11, 2019. DOI: 10.1176/appi.pn.2019.5b21.

- P. Raile, “The usefulness of ChatGPT for psychotherapists and patients,” Humanities and Social Sciences Communications, vol. 11, no. 47, 2024. DOI: 10.1057/s41599-023-02567-0.

- H. Na, “CBT-LLM: A Chinese Large Language Model for Cognitive Behavioral Therapy-based Mental Health Question Answering,” arXiv preprint arXiv:2403.16008, Mar. 2024. DOI: 10.48550/arXiv.2403.16008.

- A. Xu, D. Yang, R. Li, J. Zhu, M. Tan, M. Yang, W. Qiu, M. Ma, H. Wu, B. Li, F. Sha, C. Li, X. Hu, Q. Qu, D. F. Wong, and R. Xu, “AutoCBT: An Autonomous Multi-agent Framework for Cognitive Behavioral Therapy in Psychological Counseling,” arXiv preprint arXiv:2501.09426, Jan. 2025. DOI: 10.48550/arXiv.2501.09426.

- S. Lee, J. Kang, H. Kim, K.-M. Chung, D. Lee, and J. Yeo, “COCOA: CBT-based Conversational Counseling Agent using Memory Specialized in Cognitive Distortions and Dynamic Prompt,” arXiv preprint arXiv:2402.17546, Feb. 2024. DOI: 10.48550/arXiv.2402.17546.

- H. Kong, S. Zhang, J. Li, M. Xiao, J. Xu, and K. Chen, “HuixiangDou: Overcoming Group Chat Scenarios with LLM-based Technical Assistance,” arXiv preprint arXiv:2401.08772, Jan. 2024. DOI: 10.48550/arXiv.2401.08772.

- M. Mao, P. Ting, Y. Xiang, M. Xu, J. Chen, and J. Lin, “Multi-User Chat Assistant (MUCA): a Framework Using LLMs to Facilitate Group Conversations,” arXiv preprint arXiv:2401.04883, Jan. 2024. DOI: 10.48550/arXiv.2401.04883.

- M. Sung, S. Lee, J. Kim, and S. Kim, “Context-Aware LLM Translation System Using Conversation Summarization and Dialogue History,” arXiv preprint arXiv:2410.16775, Oct. 2024. DOI: 10.48550/arXiv.2410.16775.

- D. A. Clark, “Cognitive Restructuring,” in The Wiley Handbook of Cognitive Behavioral Therapy, John Wiley & Sons, Ltd., 2013, pp. 1-22. DOI: 10.1002/9781118528563.wbcbt02.

- J. O. Prochaska and W. F. Velicer, “The transtheoretical model of health behavior change,” American Journal of Health Promotion, vol. 12, no. 1, pp. 38-48, Sep.-Oct. 1997. DOI: 10.4278/0890-1171-12.1.38.

Acknowledgement

This project was conducted with complimentary access to the Claude API provided through Anthropic’s Student Builder Program.

This study was conducted under the supervision of Professor Ha-Young Oh.